Model: "sequential"

_________________________________________________________________

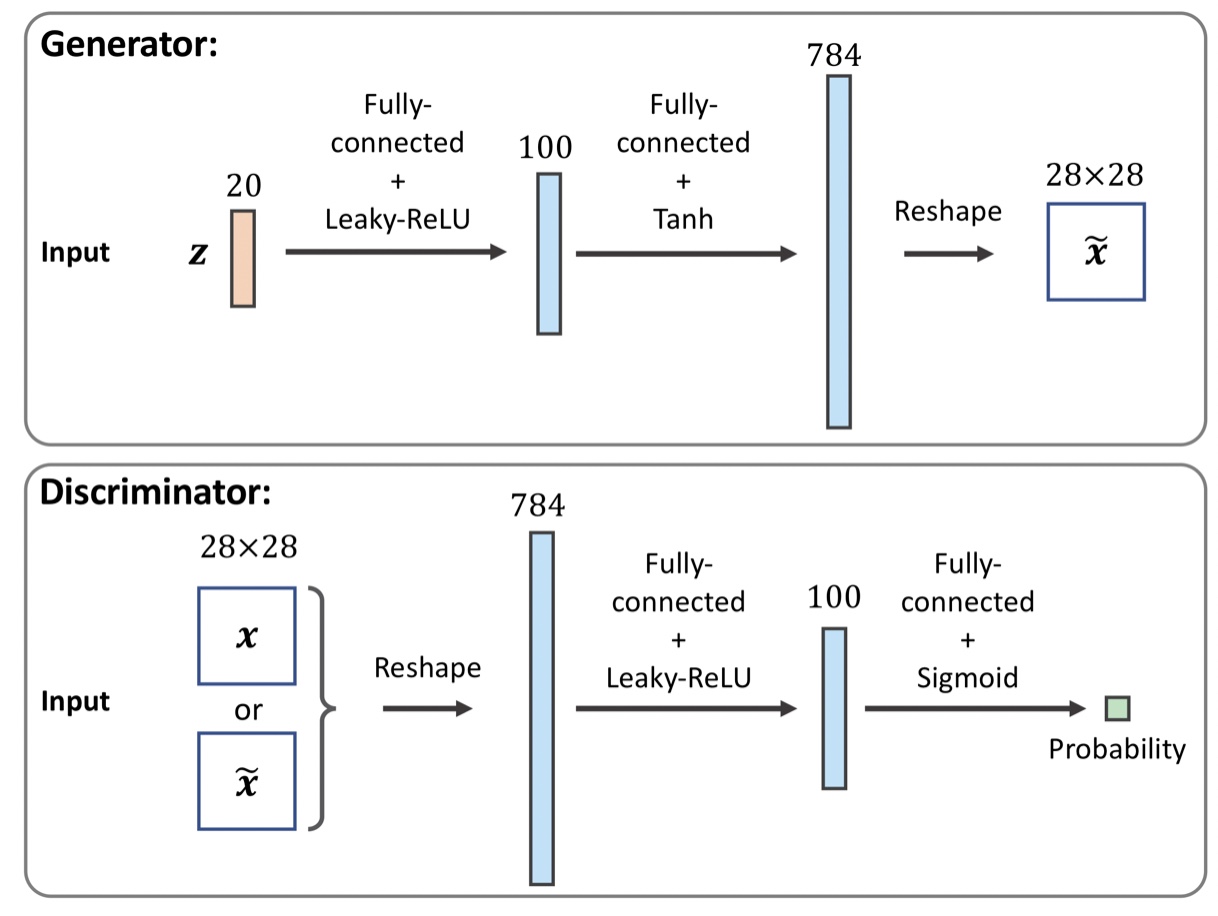

Layer (type) Output Shape Param #

=================================================================

dense (Dense) (None, 100) 2000

_________________________________________________________________

leaky_re_lu (LeakyReLU) (None, 100) 0

_________________________________________________________________

dense_1 (Dense) (None, 784) 79184

=================================================================

Total params: 81,184

Trainable params: 81,184

Non-trainable params: 0

_________________________________________________________________

Model: "sequential_1"

_________________________________________________________________

Layer (type) Output Shape Param #

=================================================================

dense_2 (Dense) (None, 100) 78500

_________________________________________________________________

leaky_re_lu_1 (LeakyReLU) (None, 100) 0

_________________________________________________________________

dropout (Dropout) (None, 100) 0

_________________________________________________________________

dense_3 (Dense) (None, 1) 101

=================================================================

Total params: 78,601

Trainable params: 78,601

Non-trainable params: 0

_________________________________________________________________